ScalePOD(R) AI ソリューション

AI用途に最適化されたインフラ・ソリューション

最大1024ノードまで拡張可能なビルディングブロック

CPU偏重システムからデータ中心システムへ

従来のHPCシステムでは、CPUを中心とした設計が組まれてきました。HPCだけでなく、AIアプリケーションへの対応も必要になるにつれ、大規模データを全て保管し分析に活用するには、データ移動などの運用が必要になる場合が多いでしょう。ScaleWorXは、AI用途向けに、データとデータ・ライフサイクルを中心に据えた全体システムをご提供します。

拡張が容易で使い勝手の良いシステムを実現

エンタープライズHPCやAI分野の急成長に伴い、大規模データの入出力、キュレーション、保管と利用を支えるストレージに求められる性能、容量、スケーラビリティ、多目的性(脱サイロ)は高まり続けています。ScaleWorXは、様々な業界におけるITインフラの知見を活かし、最適化済みかつ、よりシンプルな全体システムを提供し、システム導入の簡素化、時間短縮に寄与します。

事前検証を活用し投資効率を最大化

大規模なシステム投資を成功させるためには、事前検証は欠かせません。サーバー、ネットワーク、ストレージのメーカー各社との緊密な連携によるサポート体制を有するScaleWorXが、ラック丸ごとのシステム検証を実施することにより、事前に正しい投資判断を行うことが可能です。

主な特徴

AIワークロード用サイジング

高速なデータ収集・前処理、学習、推論を可能にするハードウェア構成

ターンキーソリューション

- AI研究者がすぐに使い始めることができるパッケージ化されたシステム

- OS: Ubuntu, RHEL

- GPUプラットフォーム:NVIDIA®CUDA®

- 機械学習ライブラリ:TensorFlow

- 深層学習ライブラリ:PyTorch

- 大規模言語モデル:Llama 2

- グラフィカルな対話操作:Open OnDemand

高コストパフォーマンス

- NVIDIA® H100 Te㎱ orコア GPU搭載のScalePOD®AI サーバー

- NVIDIA® Grace Hopper Superchip搭載サーバー(2024/Q1 出荷開始予定)

- DDN®A³I™ソリューションの最新ストレージ AI400X2™

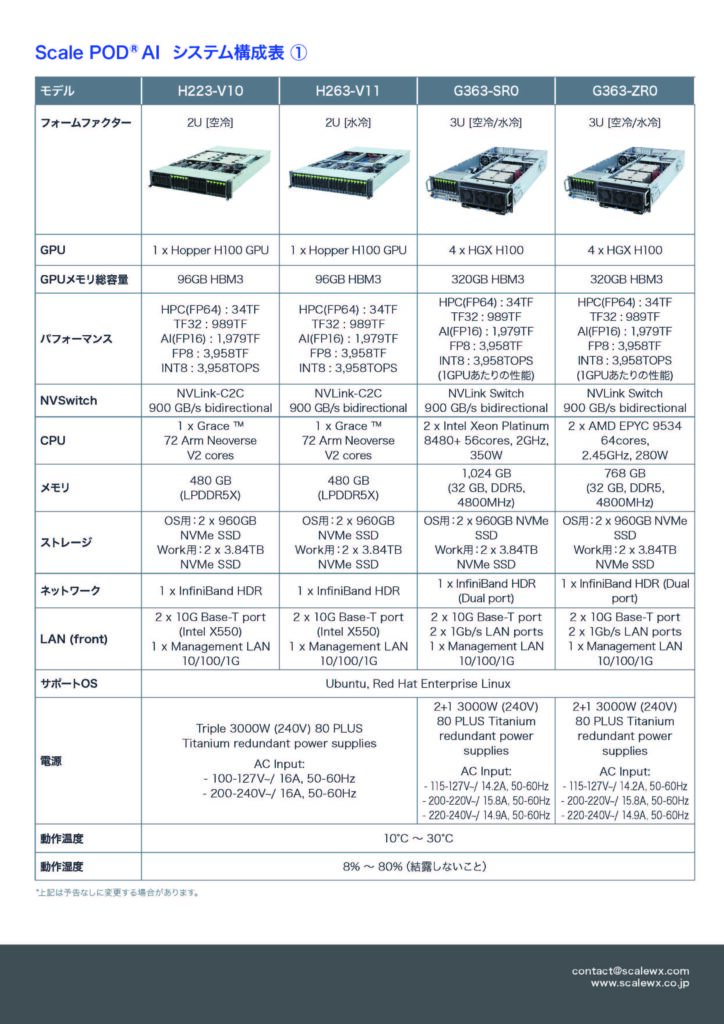

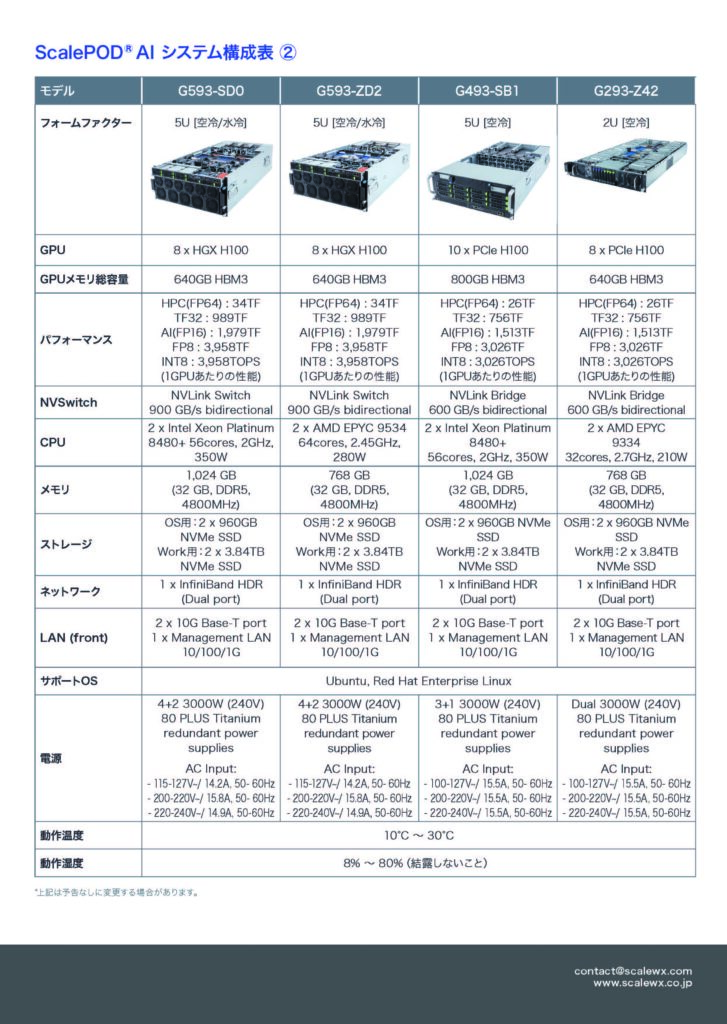

ScalePOD® AI サーバー

ScalePOD®AI サーバーは、AI学習/推論や、HPC用途に最適なハイパフォーマンスサーバーです。NVIDIAの最新GPU H100のあらゆるフォームファクターに対応しており、また4th Gen Intel Xeon / AMD EPYC 9004プロセッサーと柔軟に組み合わせることが可能なため、幅広いHPC/AIワークロードを飛躍的に性能向上させます。

・ H223/263:HPC/AI Arm Server – NVIDIA Grace Hopper Superchip

・ G293/363/493/593:HPC/AI Server ‒ NVIDIA H100+AMD EPYC 9004 / 4th Gen Intel Xeon

また、NVIDIA GPU で AI を構築および実行するために最適化された100 を超えるフレームワーク、学習済みモデル、開発ツールが備わっているNVIDIA AI Enterpriseに対応。AI チャットボット、レコメンデーション エンジン、ビジョン AI など、H100 で高速化する AI ワークフローを構築するために必要な AI フレームワークおよびツールが活用できるようになります。

主な特徴

- H100 Tensor コアにより幅広いHPC/AIのタスクにおけるマトリックス演算を高速化

- 新しいTransformer EngineはFP8 と FP16 を動的に選択し、リキャストとスケーリングを自動的に処理することで、前世代のA100 と比較して、大規模言語モデルの AI トレーニングを最大 9倍、AI 推論を最大 30 倍高速化

- DPX 命令により動的プログラミング アルゴリズムの処理を CPU と比較して 40倍、前世代の A100と比較して、7倍に高速化

- マルチインスタンスGPU(MIG)により、1つのGPUで最大7個のGPUインスタンスで仮想環境のマルチテナント/マルチユーザー構成をサポート、サービス品質(QoS)を最大化

- NVIDIAコンフィデンシャルコンピューティングにより、ハードウェアおよびハイパーバイザーレベルで各インスタンスを分離

その他コンポーネント

高性能ネットワーク

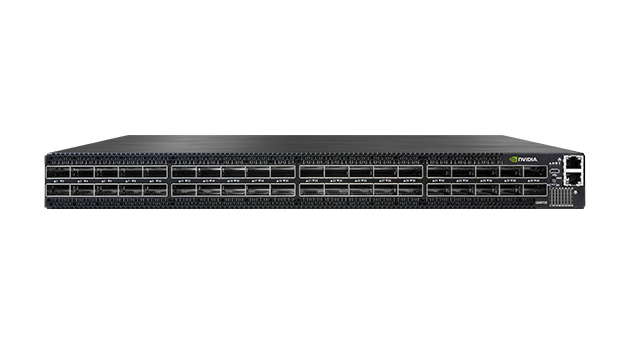

- NVIDIA Quantum 400Gb/s NDR InfiniBand Switch QM9700 series, 64 ports

- パフォーマンス:400Gb/s(ポートあたり)、データスループット合計:最大51.2Tb/s

- OSFPコネクタ、パッシブ/アクティブカッパー、アクティブファイバーケーブル対応

- NVIDIA Quantum 200Gb/s HDR InfiniBand Switch QM8700 series, 40 ports

- パフォーマンス:200Gb/s(ポートあたり)、データスループット合計:最大16Tb/s

- QSFP56コネクタ、パッシブ/アクティブカッパー、アクティブファイバーケーブル対応

高速・大容量ストレージアプライアンス

- DDN AI400X2 1台 500TB/ 300万 IOPS/ 読み込み最大90GB/秒

- 容量と性能をリニアにスケールアウト:高IOPSのオールフラッシュ領域からHDD/NVMeのハイブリッド構成が可能

- NVIDIA GPUDirect®Storageに対応し、I/Oパスのボトルネックを解消

- NVIDIA Quantum 200Gb/s HDR InfiniBand Switch QM8700 series, 40 ports

- 高可用性:各コンポーネント(ネットワーク、ファイルサービス、コントローラー、SAS HBA、エンクロージャI/Oモジュール)が冗長構成

- Top500で第9位にランクインしているNVIDIA 社「Selene 」や、NAVER社CLOVA(音声認識、画像認識、人工ニューラルネットワークによる翻訳を統合したAIプラットフォーム)をはじめ、様々な大規模AIワークロード環境での実績多数

AIライブラリ

- 下記すべてがプリロード・動作確認され出荷

- OS:Ubuntu 23.04 LTS、Red Hat Enterprise Linux 9.2

- GPUプラットフォーム: NVIDIA® CUDA®

- 機械学習ライブラリ:TensorFlow

- 深層学習ライブラリ:PyTorch

- 大規模言語モデル:Llama 2

- グラフィカルな対話操作:Open OnDemand

製品の詳細、価格についてはこちらよりお問い合わせください。